(本文是笔者写作与沟通课程的期末最终论文)

摘要:自动化技术在航空业内得到了广泛应用,飞行员的职责逐渐由操控飞机飞行转变为对自动化系统的监控。这样的转变使得航空安全面临着新的挑战,其中自动化系统的透明度问题是引发航空事故的重要因素之一。本文通过基于自动化信任理论的分析,发现维持适当的透明度对于保障航空安全是十分必要的,且提高自动化系统的可视化程度或加强对自动化故障的处理训练等方式可有效解决自动化系统的透明度问题。

关键词:航空安全;自动化系统;自动化信任;系统透明度

一、引言

随着自动化技术的不断发展,飞机已经成为现代社会中非常重要的交通工具,极大地提高了人们的交通运输效率。然而由于飞机的大部分时间的航行高度较高,速度较快,一旦在飞行途中发生事故,难以得到有效的救援。因此,保障航空安全是至关重要的。

引入协助飞行员操控飞机的自动化系统可以保障飞行安全、提升导航精度、增强飞行员对飞机状态及环境的了解、减轻飞行员工作负荷等,同时也引入了全新的失误模式,例如可能人-机交互存在障碍或发生自动化系统故障。对此学界基于许多不同角度开展了不少研究,有的研究探讨驾驶员的自动化依赖现象的影响,有的研究则从自动化惊奇现象的角度分析等。但其中关于自动化系统的透明度因素的研究大都比较片面,仅讨论了透明度较低时可能产生的航空安全问题,而忽略了自动化系统透明度过高可能引发的风险以及可视化,即数据的显示方式等因素对飞行员操控的影响。

考虑到飞行员对自动化系统的信任是理解人-机交互的重要概念,本研究希望以自动化信任的理论为视角切入,通过分析实际的空难案例,尝试论证自动化系统的适当透明度对于保障航空安全的必要性,并提供一些解决系统透明度问题,减少航空事故的发生的途径。

二、相关概念界定

(一)自动化信任

有大量的研究者调查过信任在影响人际交往关系中所起到的作用,目前学界对于信任提出了不同的定义。一些研究者认为信任是一种态度或期望,有的研究者将信任概念化为一种行动的动机或意愿,还有的研究者将信任定义为一种信念 。其中一个得到学界广泛认可的定义是“在一个充满不确定性及脆弱性的情境下,对于目标对象会帮助实现个体目标的态度”。特别地,自动化信任是特指目标对象是自动化系统的情况,即人对于自动化系统的信任程度。

为更细致地研究自动化信任,目前主流观点大致分为三个主要的类别:倾向性信任,情景信任及习得信任。倾向性信任是指操作者本身对于信任自动化的个人倾向性,可能受到地域、性格、年龄等因素的影响。情景信任是指处在特定的环境背景之下,操作者对于自动化的信任程度,影响因素主要可以分为外部因素(任务复杂程度、自动化的可靠性、工作量大小、决策风险等)和内部变量(自身情绪、自信等)。习得信任是指基于过去的某些经历产生的信任或不信任,包括对系统构造的理解、自动化系统的声誉、期望值等。

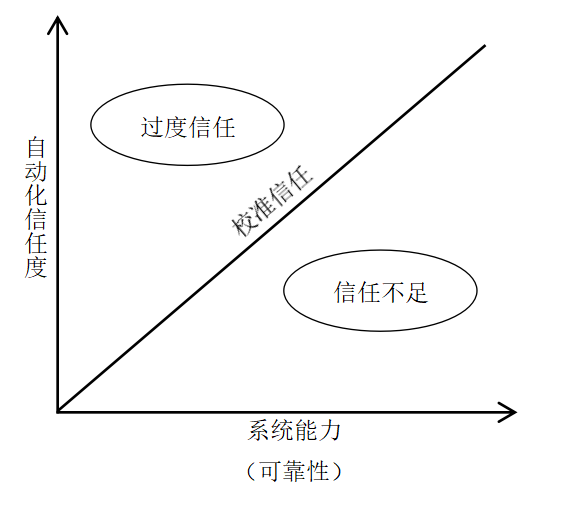

对于自动化系统不适当的使用主要体现为滥用或弃用,出现哪一种情况取决于对自动化系统的信任程度是高于还是低于其真实能力(可靠性)。自动化信任与系统能力之间的关系主要分为校准信任、过度信任、信任不足三种。校准是指人对自动化的信任程度与自动化系统的能力之间的对应,而校准信任则代表信任与能力校准时的信任状态,此时对自动化系统的使用是恰当的。信任超出系统的能力时的不良校准情况称为过度信任,此时可能会导致对于自动化的滥用;而信任低于系统能力时称为信任不足,此时可能会导致弃用自动化系统。

(二)自动化的透明度

为了更好地进行人-机交互,人们往往需要能够精确地感知自动化系统的能力、目的以及状态。用于描述人们对于自动化系统的感知程度的量被称为自动化系统的透明度。虽然这一概念是直观的,但为方便量化研究,学界给出了一些不同的定义。在先前的一篇研究中,透明度被定义为“人类对于‘为什么系统出现非预期行为’的理解程度”,该研究表明人对自动化的感知程度很大程度上受到透明度的影响。另一些研究从对系统可靠性的理解程度来定义透明度,并论证了提供有关系统可靠性的信息有助于校准人们对于自动化系统的信任程度。综合来说,自动化系统的透明度可以定义为“在人-机团队中,为促进意识与意图的共享,开展的以人为主的要素和以系统为主的要素的交流”。

Lyons给出了一个自动化系统透明度的设计框架,他将系统透明度分为四个要素:意图模型、任务模型、分析模型以及环境模型。意图模型需要表现自动化系统的设计、目的以及意图。换句话说,人们需要清晰地了解系统设计的初衷,是为了照顾老弱病残、提供情感上的支持、提高工作效率或者其他形式的帮助。一旦用户清楚了系统的目的,接下来他们就可以开始分析在特定的认知框架下系统的行为了。任务模型就提供了这些详细信息,具体主要包括系统对特定任务的理解,在指定时间内的目标信息、目标的完成进度信息、对系统能力的认识、以及对可能出现的错误的认识。同时,为了让人们明确系统是如何进行数据的分析与决策的,系统需要描述其做决策时的基本原则,这就是分析模型。最后,环境模型描述的是系统对于周围环境的了解,包括地形变化、天气情况、可能存在的威胁等因素。这些信息有助于人们校准他们对于自动化系统的依赖程度。

三、适当透明度的必要性分析

不适当的透明度主要体现为透明度过低以及透明度过高两种情况,这两种情况都可能导致飞行员的自动化系统过度信任或信任不足,导致人-机交互中出现交流过少或交流不畅等情况,进而对飞机的航空安全产生威胁。本文接下来的部分将一一分析这些情况产生的具体原因及案例。

(一)透明度较低的问题

当透明度过低时,如果出现飞行员不理解的自动化惊奇现象,使飞行员对自动化系统失去信任;反之,如果飞行员没有经历过自动化惊奇现象,则可能会盲目信任自动化系统。

1. 自动化惊奇现象

在飞行过程中,系统给出的环境模型是飞行员了解飞行环境状况的重要途径。在环境模型过于模糊时,可能会造成飞行员的情景意识丢失。其中情景意识是指“在一定的时间和空间内,对于环境元素的洞察力,对它们的意义的理解力以及对它们在不久的将来时的状态的预测能力”。在缺少情景意识且系统的任务模型信息缺失的情况下,飞行员无法获取环境与系统的完整状态信息,因而可能会对自动化系统做出的行为决策感到惊奇或难以理解。这一现象被称为自动化惊奇。换而言之,自动化惊奇是一种飞行员的心理预期与自动化系统行为失配的现象。当发生此类现象时,飞行员可能会感到惊吓,使他们无法冷静思考,对自动化系统的情景信任急剧下降,同时工作负荷与压力陡然增加。一旦超出飞行员能力的承受范围,就可能会导致飞机的失控。同时,自动化惊奇现象一般来说都伴随着概率极低的“黑天鹅”(非预期)事件的发生,因此诱发自动化惊奇的因素可能在飞行员注意到自动化系统的出乎意料的行为之前,就已经对飞机操控产生了影响,造成了严重的后果。经历多次自动化惊奇事件可能会降低飞行员的习得信任,导致飞行员对自动化系统的信任不足,在人-机交流中产生隔阂,对于操控飞机存在分歧,稍有不慎就可能发生严重的安全事故。

1994年,中华航空140号班机从中国台北飞往日本名古屋途中坠毁。在飞机降落时,机长关闭了自动驾驶系统改为手动驾驶,然而副机长在操控时意外触碰到了复飞按键,导致自动化系统开始尝试让飞机抬升。然而由于空客A300飞机对于复飞的提示非常不清晰,导致机组成员并未注意到复飞模式开启,机长仍在尝试压低机头。但根据飞机的程序设定,此时自动化系统的操控权高于人类,所以机长无论如何努力都无法压低机头,最终无奈放弃选择复飞。接着机长手动拉杆以增加仰角,导致飞机仰角猛然增大,最终失速坠毁。 在这起空难事故中,机长面对无法压下机头的自动化惊奇现象虽然果断选择了复飞,但由于自动化透明度过低,机长并没能发现引发这一现象的原因,对自动化系统的情景信任降低,人-机之间的缺少交互,造成飞行员与自动化系统同时上扬机头,致使空难发生。因此系统透明度过低时,可能会出现自动化惊奇现象,飞行员不能完全理解飞机的状态,使得人-机交互之间产生隔阂,引发严重的事故。

2. 过度信任与自动化依赖现象

因为系统的透明度较低,飞行员无法获取自动化准确的状态与目的,以及周围环境的状况。如果飞行员在长期的飞行过程中并未经历过自动化系统失控且飞行员本身的对自动化系统的倾向性信任较高,那么他有对自动化系统的习得信任就可能会盲目增长,最终信任程度超过系统的能力,引起过度信任,产生自动化依赖行为。在这种情况下,飞行员手动操控飞机的次数及时长会越来越少,而选择将大部分的决策权交予自动化系统。然而如果长期使用自动化技术,操作者的手动执行任务的能力可能会随着时间的推移而逐渐下降,这一现象被称为去技能化。受此影响,一旦自动化系统出现 “黑天鹅”事件,飞行员往往并没有做好接管飞机操控的准备,同时由于飞行员无法准确获知系统状况,不清楚如何迅速解决自动化系统存在的问题,从而导致航空安全事故的发生。

2009年,法航AF447航班在从巴西里约热内卢飞往法国巴黎的途中坠入大西洋。事故调查表明,飞机失事的主要原因可能是当时恶劣的天气导致飞机的皮托管被冻结,使得飞机失去正确的大气数据。然而在自动驾驶系统断开之后,副机长对操作不熟练下意识地向下拉操纵杆导致机头抬升,飞机失速。且由于飞机自动化系统启用了备用法则,并没有提示飞行员飞机已经失速,最终在海上坠毁。事实上,这场事故本应是可以被完美的解决的,因为空客飞机的检查单上针对皮托管被冻结而产生的“空速不可靠”状况有着详细的解决方案且并不复杂,只要经过训练、处理得当,完全不会威胁到飞机的安全。但是由于自动化系统透明度不够,副机长没能及时找出飞机出现的问题,且自身对自动化系统过度信任与依赖、对飞机出现意外状况时的操控不熟悉,最终才导致了这场空难。

1998年,又一架中华航空飞机在降落时坠毁。华航676号班机从印尼巴厘岛飞往中国台北,降落时,机长为了能尽快捕获下滑道并降落,过于用力地向前推动了操纵杆。而由于94年中华航空事故的影响,空客将程序修改为“当飞行员下压操纵杆的力度超过15公斤时飞机强制关闭自动驾驶同时解出复飞模式”。这却导致这架飞机在降落过程中意外关闭了自动驾驶系统。且机组成员并未注意到自动化系统给出的三声提示音,造成这一情况的部分原因就是系统的透明度不足。在机长决定复飞时过度信任自动化系统,认为自动化系统会自动控制飞机的仰角,就没有将注意力放在监控自动化系统的状态上,同时系统也没有及时做出提醒。最终发现飞机仰角过高时已无力回天。 在这起空难中,空客设计的自动化系统没有解决本质性的问题,系统的透明度仍然过低,且飞行员过度信任自动化系统,认为其会辅助调整飞机仰角,而没有自己对飞机的仰角进行监控,从而使得飞机坠毁。因此,自动化系统透明度过低可能会导致飞行员过度信任且依赖于自动化系统的操控,因而威胁到航空安全。

(二)透明度较高的问题

当透明度过高时,飞行员收到的信息超过认知容量,导致工作负荷增加、情景意识下降。同时这可能会导致飞行员下意识地按照自动化系统的指示进行操作,而没有对每条信息进行分析;或认为自动化系统给出了过多无用信息,从而失去对其的信任。

1. 超过认知容量

认知容量一般指大脑在特定的时刻能够保留的总信息量。如果系统的透明度过高,由于自动化系统与飞行员的交流信息过多,飞行员无法分清重点信息以及不注意的信息,只能尝试全部记录,然而一旦信息总量超出飞行员的认知容量,就可能使得飞行员忽略掉部分关键信息,且急切地想要处理掉大部分信息,工作负荷激增、情景意识降低,从而引发严重的航空事故。

2. 自动化偏见

自动化偏见是指人类对于赞成自动化决策系统的决定并忽略与之矛盾的信息的倾向性。在透明度过高的情况下,由于工作负荷过大,更可能会产生这种对自动化过度信任而引起的自动化偏见现象。同时因为飞行员无法逐一分析自动化系统发出的信息,所以哪怕自动化系统提供了错误的建议或指示,飞行员也会倾向于相信这些信息,从而犯下错误。

如果飞机出现严重的积冰现象且飞行员操作不当,很有可能会造成航空事故。而早年的一项研究中调查了发生飞机积冰现象时飞行员与自动化决策支持系统之间的交互,研究结果表明,即使飞行员自身观察到的情况与决策支持系统给出的建议相矛盾,飞行员仍会下意识地按照自动化系统的建议进行操作。由此可以看出自动化偏见现象对于航空安全存在严重威胁。

3. 过度警报

当任务模型比较复杂时,自动化系统可能会显示出过多的状态信息,并将大量可能存在风险的状态全部列为警报。此时飞行员需要花费大量时间去理解每个警报产生的条件、原因等,而无法顾及其他更优先的工作。在多次看到相同的、无关痛痒的警报后,飞行员对于自动化的信任程度就会降低,从而产生信任不足的现象,认为自动化系统提出的警报都不需要飞行员采取任何行动。因此,有些飞行员为了降低工作负荷而选择关闭警报系统,而这恰恰是灾难性事故的根源。

2015年,特里加纳航空267号班机在从印尼的森塔尼飞往奥克西比尔的途中坠毁在机场旁的一座山上。当时飞机在准备降落时恰好飞进了一片云层,能见度过低,飞行员只能通过自动化系统的提示来避开山体。但直至飞机撞在山上坠毁时驾驶舱内都没有响起任何警报。这是因为当地的地形数据绘制非常的粗糙,飞机经常在爬升或降落时莫名其妙收到地形警报,因此飞行员对于飞机的地形警报系统不信任并选择了关闭这一系统。事实上,即使飞行员当时没有关闭系统,因为他们对于警报系统的不信任,在云层中他们或许仍会认为警报是假的。这最终导致在飞机即将撞山时飞行员没能及时做出反应。这说明,如果出现了过多的警报,飞行员就可能会对自动化系统的信任不足,从而导致危险真正出现时飞行员无法及时采取补救措施。

综上所述,如果飞机自动化系统的透明度程度不适当,则可能会导致自动化惊奇、过度信任、自动化偏见或过度警报等对自动化系统的信任不当问题,进而引发严重的飞行事故。因此,保持自动化系统的适当透明度对于保障航空安全是非常必要的。

四、解决透明度问题的途径

解决透明度问题是减少航空事故发生的一个重要方法,而为了解决自动化系统的透明度问题,可以采取提高自动化系统的可视化程度或加强关于自动化故障的处理训练等方法。

(一)提高可视化程度

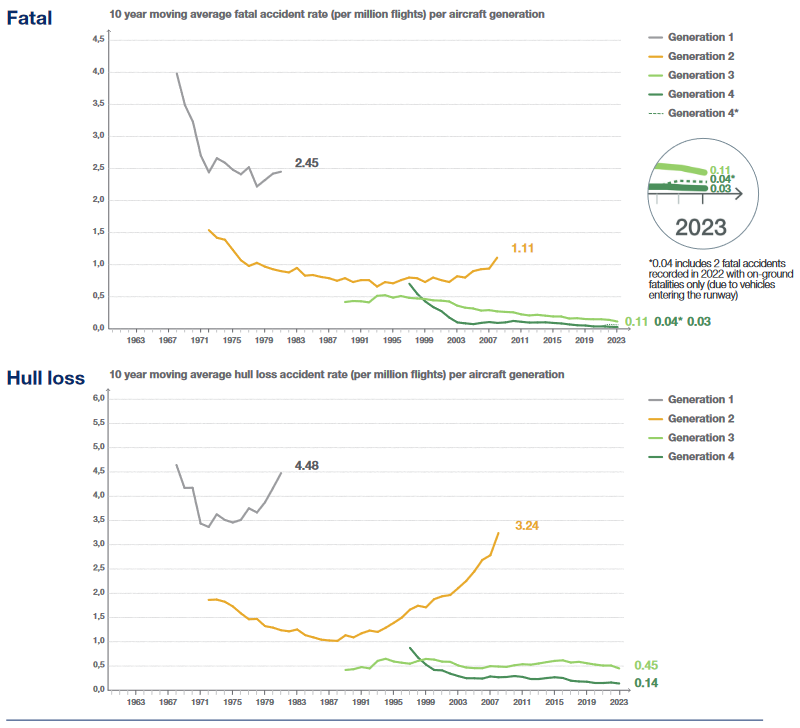

改进信息的显示方法,可以使系统提供的数据更加直观、易理解,从而解决透明度过高时造成的信息超出认知容量的问题。在这种情况下,飞行员就能够快速筛选出自己所需要的信息,在不损失信息的获取速度的情况下,提供尽可能详细的信息。在航空史上,通过提高可视度的方式,保障航空安全就曾在将二代航空自动化系统升级为三代时发生过。当时喷气式飞机由机电驾驶舱更迭为玻璃驾驶舱,并广泛使用数字微处理器以代替原先的机电仪表。这样的显示方式让飞行员能够更加直观地了解飞机的各种飞行数据,大幅提高了驾驶舱的数据可视化程度。图2中空客的统计数据表明,驾驶舱经历了从二代到三代的升级后,航空事故率大幅降低。

(二)加强对自动化故障的处理训练

经过以上的分析可以发现,大部分由透明度问题引起的航空安全问题都是在自动化系统失控时,飞行员操纵不当导致的。因此对自动化故障的处理训练能够帮助解决这一问题。这样的训练不仅可以提高飞行员对于自动化系统与手动操控的熟悉程度,增进人-机合作,防止去技能化现象的出现;还可以起到校准飞行员对自动化系统信任程度的作用;同时可以让飞行员在真正遇到“黑天鹅”事件时能够冷静应对,增强情景意识,尽量减少自动化惊奇现象的发生。

五、总结

基于自动化信任的理论分析以及对空难案例与数据的分析可以发现,保持航空自动化系统的适当透明度对于减少航空事故的发生,保障航空安全是十分必要的。但本研究依然存在一定的局限性,首先研究中对于一些潜在的威胁航空安全的因素仅仅只做出了理论的存在性分析,而并未进行定量的计算出哪些因素是主要的,哪些是次要的。其次对于如何解决自动化系统的透明度问题,文中仅举出两例,未来可能可以针对更多的解决途径以及相应的具体措施进行补充。例如,如果技术上能够实现完全自动化的无人商用飞机,这是否会成为一个完美的解决方案?如此的话地面上的操作人员是否会对这样一个新的系统产生信任与依赖?乘客是否能够接受将自己的人身安全完全交给冰冷的机器?……这些都是未来值得研究者们一探究竟的问题。